AI的未来不应受到限制,而应该是“Liquid”。

作者|苏霍伊

北京时间10月23日,美国初创公司Liquid AI在麻省理工学院(MIT)的Kresge礼堂举办了产品发布会。揭晓了利用Liquid基础模型的首批企业级产品。

Liquid AI基于第一原理,打造出了一种非Transformer架构的动态引擎——液态神经网络(Liquid Neural Network,LNN)。通过将神经科学、物理学和动力系统的原理融入其模型设计中,Liquid AI在可解释性和效率方面实现突破。LFM模型采用了与数学和信号处理领域相似的数学原理,因此它们特别适合处理多种类型的数据,包括文本、音频、图像和视频。

诚然,OpenAI的ChatGPT和谷歌的Gemini可能正在引领人工智能革命,但这家小型初创公司也在用实力向世人证明,创新仍然具有颠覆性力量。

在昨日在宣传片中,Liquid AI的CEO Ramin Hasani更是直言“Liquid引擎才是真正的创新”。“它能让每家公司都拥有自己专属的AI解决方案,我们创建Liquid AI,是为了让人们能以更智能的方式接触GenAI。”他说道。

「甲子光年」发现,LFM的特点主要有:

提升决策质量:LFM拥有先进的知识处理能力,特别适合解决需要深度知识背景的任务,能在这些场景下展现出色的表现。

效率与可持续性:这些模型因为内存使用低和推理速度快而极具效率,训练和部署都能节省大量资源。此外,它们能在本地设备上高效运行,大大减少了对云计算的依赖,有助于降低成本和环境影响。

增强可解释性:与传统基于Transformer的模型相比,LFM的设计原理更加清晰,提供了更好的透明度,用户可以更容易地理解和监控模型的决策过程。

Liquid AI产品发布会现场,来源:「甲子光年」拍摄

Ramin Hasani表示:“Liquid AI让我们以全新的视角面对AI系统。我们将从底层改变AI。”

三周前,Liquid AI发布了首批基于液态神经网络的多模态大模型——Liquid Foundation Models(LFM),包括1.3B、3B和40B三个版本。这些生成式AI模型在各种AI任务中展现出优越性能,它们不仅具有较低的内存需求和更高的推理效率,同时在多个规模上都达到了行业领先的性能水平。

在发布会上,他们又推出了两款新产品——音频LFM和视觉LFM。

音频LFM拥有近40亿参数,能直接在设备上运行。它支持无缝音频生成,能进行语音到语音转换和语音到文本转换。视觉LFM能处理文本与图像,还能在图像上添加上下文,可以在边缘和本地使用这些新基础模块解锁许多应用。

它们可用于检测金融交易欺诈、控制自动驾驶汽车和分析基因数据等。三星、Shopify等公司正在测试这项技术。

Ramin Hasani特别提出Liquid“不仅仅是一种AI架构”。“我们确实在AI架构上取得了创新,但架构只是基础模型公司的一部分。我们正在构建一个完整的模型开发生态系统,不仅在架构上创新,还在学习算法、训练方式、评估方法等方面进行突破。”他说道。

Ramin Hasani,图片来源:Liquid AI

创始科学家Jimmy Smith介绍了Liquid AI是如何“拔高”模型质量的。“掌握知识能力、多步推理,并关注推理、训练的效率。在特定部署场景下,我们不仅仅关注模型架构,还考虑数据、训练算法和后期训练的相互作用。”Jimmy Smith说。

Jimmy Smith,图片来源:Liquid AI

高级科学家兼后期训练负责人Maxime Labonne介绍了Liquid AI“最重要的后期训练”。“通过创建高质量的示例,让模型学习如何分步回答复杂问题,我们还需要评估模型的聊天功能以及与用户的交互方式。”Maxime Labonne表示:“以及最令人兴奋的模型合并。在模型合并过程中,我们将同一模型的不同版本的参数合并,创建出统一的高质量模型。”

Maxime Labonne,图片来源:Liquid AI

电子商务公司Shopify的首席技术官、前微软高管、Liquid AI顾问Mikhail Parakhin(左三)表示,赢得人工智能竞赛最终将需要数百亿美元。“甚至一千亿美元。对于Liquid AI而言,目前实现这一目标是一项艰巨的任务。”Mikhail Parakhin说,“但他们拥有一项非凡的技术。”

State of Generative AI的讨论,来源:「甲子光年」拍摄

马萨诸塞州州长Maura Healey也来到现场。她说道:“Liquid AI让我想起了美国独立战争中在列克星敦和康德科(隶属大波士顿区)打响的第一枪,麻州始终致力于革命和创新。”她表示,Liquid AI为马萨诸塞州带来难得的机遇,让东海岸也能在AI行业中占据一席之地,而不至于被硅谷远抛在后。

Ramin Hasani与Maura Healey,图片:「甲子光年」拍摄

目前,Liquid AI已筹集近5000万美元,但可能还需数亿美元才能完善其AI应用。

Liquid AI起源MIT计算机科学与人工智能实验室(CSAIL)。其联合创始人之一是Daniela Rus是MIT CSAIL的主任,同时她也是Andrew和Erna Viterbi教授。与Daniela Rus一同创立Liquid AI的还有三位来自CSAIL的杰出博士后研究员。

Ramin Hasani在加入MIT前,曾是美国最大的基金管理公司之一先锋集团(Vanguard)的首席人工智能科学家;Mathias Lechner在维也纳工业大学读书时就与Hasani共同研究线虫的神经结构,这一研究对他们开发液体神经网络的工作至关重要;首席科学官Alexander Amini则是Daniela Rus的博士生。

而LFM技术源自2020年底,Ramin Hasani等发表的一篇名为《液态时间常数网络(Liquid Time-constant Networks)》的研究论文,这也让液态神经网络在数年的起伏后得到了广泛关注。但作为一个概念,液态神经网络自2018年起就存在。

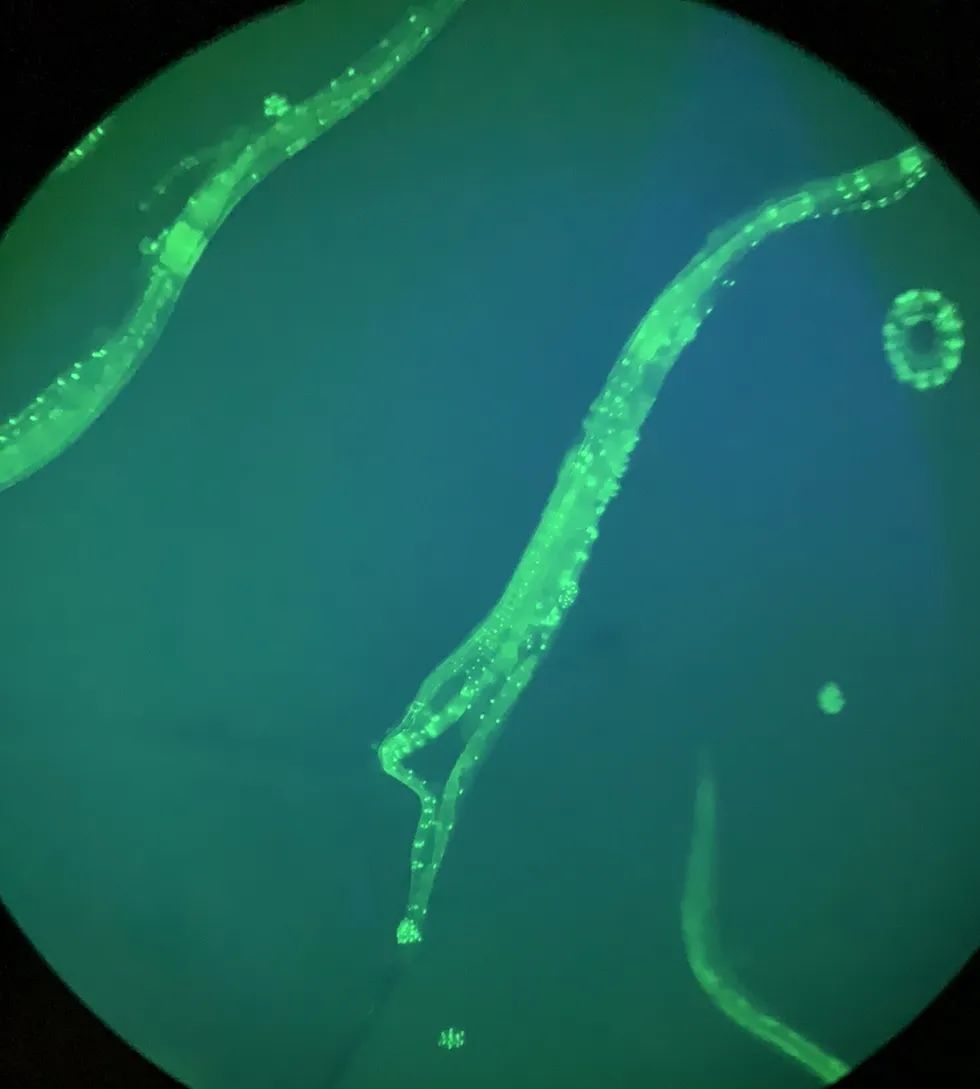

Ramin Hasani等受到秀丽隐杆线虫的神经结构启发,制造出了液体神经网络。秀丽隐杆线虫是首个完整绘制神经连接图的生物。虽体型微小,却展现出高于现有人工智能系统的学习和适应能力。它拥有302个神经元,能执行复杂行为如觅食和交配。

基于这些生物特性,Daniela Rus等科学家开发了“液态时间常数网络”,一个由简单动态系统组成的连续时间模型,这些系统通过非线性门相互作用。这种模型特点是时间灵活性高,通过解微分方程生成输出,优于传统神经网络模型,特别是在处理时间序列预测方面表现卓越。

显微镜下的秀丽隐杆线虫,来源:维基百科

LFM的一个主要优势是它能够仅用很少的数字神经元就实现高效的运作,相比于其他庞大计算资源的模型,如ChatGPT,LFM在计算芯片的使用上更为高效。OpenAI最近甚至提到,下一代ChatGPT需要达到或者依赖于国家层面的技术和资金支持,其对计算力和相关基础设施的需求已经超出了常规商业运作的范畴。

(封面图来源:「甲子光年」拍摄)

END.