(图片来源:钛媒体App编辑林志佳拍摄)

2023年11月16日起,一款名为Kimi的 AI 应用产品在中国横空出世、瞬间爆红,在苹果App Store应用商店的下载排名中,一度超越微信、抖音,冲到榜首。

被称为“中国版ChatGPT”的免费 AI 应用Kimi,能一口气直接进行200万字长文本处理,文笔比百度“文小言”(文心一言)更加流畅自然,而且引发社交平台讨论,一度让平台暂时“宕机”。

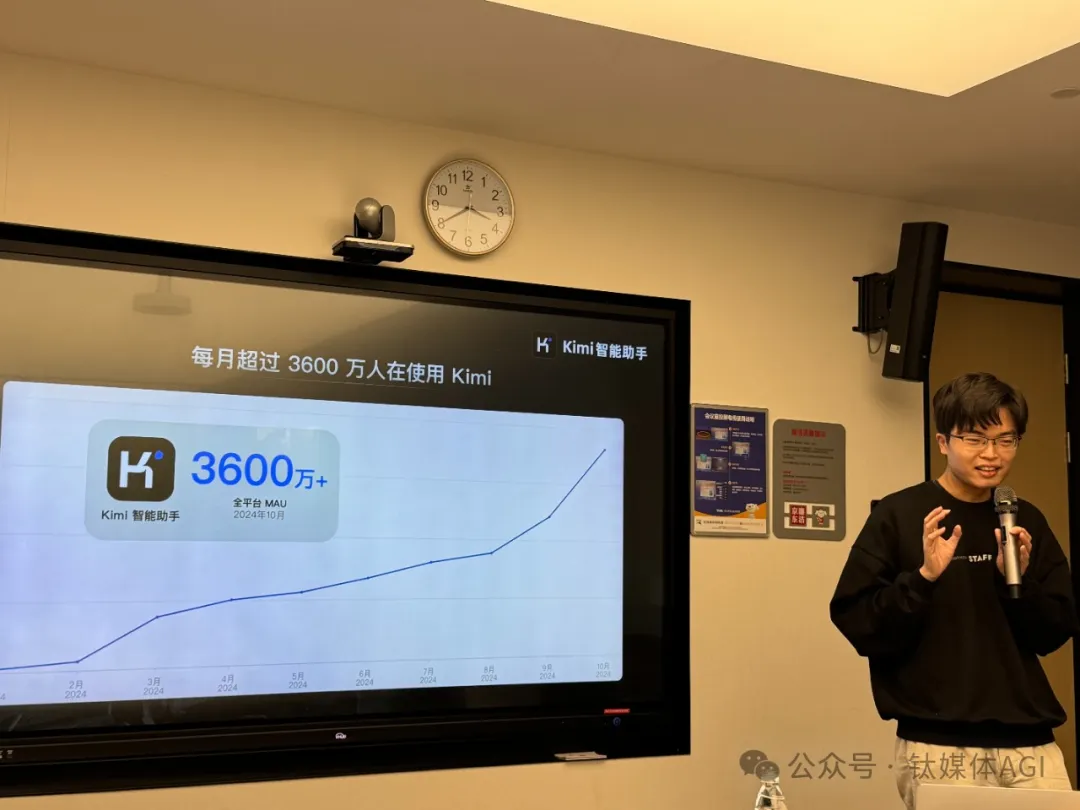

今年10月,Kimi智能助手月活超过3600万人。

Kimi智能助手背后的“缔造者”,来自一家创立约579天的AI公司“月之暗面”(Moonshot AI),公司创始人、CEO是一位31岁的连续创业者杨植麟。

杨植麟于清华大学计算机系毕业、美国卡内基美隆大学计算机博士,曾在Meta AI和Google AI研发团队工作过,同时他也是Transformer-XL与XLNet两篇重要论文的第一作者,两者均涉及大语言模型领域的核心技术,并且是中国35岁以下NLP(自然语言处理)领域引用量最高的研究者。回国后,他曾带领团队参与盘古大模型的核心技术研发,还带领其联合创立的NLP公司循环智能的产品研发。

随着Kimi智能助手爆火,过去1年多,无论是月之暗面,还是杨植麟本人,都面临着巨大的争议与热度。

首先,融资层面,月之暗面优异的 AI 技术、产品、应用和市场销售能力,让阿里巴巴、腾讯、红杉中国、美团、小红书、招商局中国基金等机构一窝蜂抢投,数月前满周岁时融资总额就已达数十亿元人民币,公司估值已超过200亿元。

其次,AI大模型市场持续“狂飙”,从“百模大战”到“价格战”、落地应用竞争、“百变 AI 应用”等,大模型领域竞争加剧,MoE(混合专家)、AI视频、实时语音对话、多模态、开源闭源、端侧模型等新技术新模式不断涌现,而在此之前,Kimi在部分产品功能层面是有所缺失的,而且在Kimi免费下,月之暗面每月大量投流和研发投入,导致市场开始怀疑其商业盈利能力和长期行业竞争力。

最后,近期杨植麟“被仲裁风波”引发关注,金沙江创投等5家前投资人向媒体透露仲裁消息,让更多人担忧接下来公司的发展情况。

围绕“昨天、今天和明天”话题,11月16日下午,北京海淀京东科技大厦,闭关技术研发数月的杨植麟,在Kimi Chat全面开放一周年日,不仅发布了对标o1的全新kimi数学模型——k0-math(未来一两周内上线kimi探索版),并且与钛媒体App等对诸多话题进行沟通与回应。

谈投放和成本:Kimi留存率很重要,这与AGI有正相关作用

最近出现 AI 创业公司被收购、人才回流的现象,你怎么看待当前 AI 发展现状。

杨植麟:我们没有遇到。我觉得也很正常,行业发展进入新的阶段,之前有很多公司在做(大模型),现在有一些小公司在做,行业发展规律。

今年2、3月份开始,月之暗面开始聚焦和缩减(出海业务),我认为应该疯狂做减法,更加聚焦。

提升留存率是很重要的,留存率和AGI是正相关过程,现在与AGI还有一定的距离,今天做的交互能力还很有限。

“我们主动选择做了业务的减法,应该聚焦把一个业务产品做好,大模型公司里面人数最少,算力卡和人的比例做的最高,公司人员规模做的不会做的很大,业务做很多减法。你看,ChatGPT有5亿人次月活,已经是超级应用,当然也有其他应用很难‘破圈’,我们看到了美国市场的情况,选择聚焦,跟AGI的未来发展有关,控制人数不要太多,而把更多聚焦到创新业务做好。”

此次公布的全新一代数学推理模型 k0-math。基准测试显示,Kimi k0-math 的数学能力可对标全球领先的 OpenAI o1 系列可公开使用的两个模型:o1-mini和o1-preview。在中考、高考、考研以及包含入门竞赛题的MATH等 4 个数学基准测试中,k0-math 初代模型成绩超过o1-mini和o1-preview模型。在两个难度更大的竞赛级别的数学题库 OMNI-MATH 和 AIME 基准测试中,k0-math 初代模型的表现分别达到了 o1-mini 最高成绩的 90% 和 83%。同时,Kimi 探索版也通过运用强化学习技术创新了搜索体验,在意图增强、信源分析和链式思考三大推理能力上实现突破。

Kimi创始人杨植麟博士介绍,k0-math 模型和更强大的 Kimi 探索版,未来几周将会分批陆续上线 Kimi 网页版和Kimi智能助手APP,帮助大家解决更有挑战的数学和搜索调研类任务。

谈与豆包竞争:不应该关注竞争本身

杨植麟:不应该更多关注竞争本身,更多应该提升思考能力,用户很大价值,能够解决AGI能力。投流不是当下考虑的重要问题。

当然,大模式推理成本问题也很重要,因此,kimi未来考虑次数限制,一个模型问题,每个用户(100次)有次数限制,让用户自己去选择。早期,kimi认为需要分配、动态更优的算力,需要想多久,简单问题想的时间很短,这是更优的。

如今,算力成本在不断下降的过程,所以依然有很大的空间。

谈多模态:我们在内测

杨植麟:关于多模态,我们在内测,我觉得AI接下来很重要是思考和交互这两个问题,然后我觉得,思考方面可能没有交互更重啊哟,就是说或者不是说交互不重要,我觉得思考会决定你的上限,然后交互我觉得是一个必要条件。

谈算力和Scaling Law瓶颈:训练明年会到天花板,但Scaling Law还有更多空间

杨植麟:我觉得训练还有空间,我觉得可能还有半代到一代模型的空间,所以但是这个空间基本上我觉得可能会在明年释放出来,明年基本上我觉得领先的模型会把必须能做到一个比较极致的阶段。

我觉得今天,比如说我们去看最好的模型,它可能还大概有这样的空间可以去“压榨”,但是我们判断,接下来可能最重点的东西可能还是会在强化学习,他的范式上可能会产生一些变化,我并不是说他不用调,只是说你会通过不同的方式去Scaling,这个是我们的判断。

然后你说,scaling Law会不会是一个天花板,或者像现在其实我觉得我还比较相对来说比较乐观一点。然后核心就在于说原来你用静态数据集,静态数据集其实你是比较简单粗暴的使用方式,现在就是说你其实理论强化学习的方式,很多情况下你是有人在参与这个过程,但是人他没有办法说给你标注那么多数据,他不可能把每道题具体的思路每道都给你标出来,所以你其实是把用AI本身去把人的东西加上一个杠杆,然后比如说你可能标100条数据,你就能产生非常大的作用,因为剩下他都是在自己在思考。

谈数据泛滥和错误率优化:整个行业会变好

杨植麟:对于强化学习来说,这是需要自己生成的,奖励模型效果,减少尽可能错误的东西,因此需要训练更多的数据,设置奖励机制,才可能解决数据泛滥等问题。

关于数据、算力和算法平衡问题,这是一个“荡秋千”的过程,来回切换,此前在GPT-4上算力不够,因此需要做更多的工程,但现在需要做更多的数据清洗,做更好质量的数据,而且机制算法的改变,这是整个行业的问题,加多少卡解决不了,因此算法层面需要做更多的scaling。

中美大模型差距:我觉得创新能力更重要

杨植麟:这是一个好事。中美没有什么变化或者说差距,本来我一直觉得还是(中美)相对是一个常数,一直会Pre-Train,明年可能不可持续,一段时间内算力不是瓶颈,创新能力很重要,对我们来说可能是一件好事。

因为他并不因为本来你不做预训练,你可能今年1亿明年10亿或者100亿,你就是受不了,它不一定可持续,这个时候你可能更多的创新能力是(对于中美AI联系)更重要。

(本文首发于钛媒体App,作者|林志佳,编辑|胡润峰)